Обучение с подкреплением – это метод машинного обучения, основанный на принципе проб и ошибок, аналогичном тому, как учится ребенок. В этом методе компьютерная программа, называемая агентом, обучает сама себя на основе опыта взаимодействия с окружающей средой.

Процесс обучения состоит из следующих шагов: агент взаимодействует с окружающей средой, выбирает действия и получает обратную связь в виде награды или штрафа. Цель агента – максимизировать получаемую награду, а для этого ему нужно научиться принимать оптимальные решения в конкретной ситуации.

Примером обучения с подкреплением может служить обучение компьютерной программы игре в шахматы. Агент начинает игру с нулевыми знаниями и делает случайные ходы. Когда игра окончена, агент получает награду в виде выигрыша или штрафа в случае поражения. На основе этого опыта агент начинает корректировать свои действия и постепенно улучшать результаты.

Обучение с подкреплением: определение и цель

Целью обучения с подкреплением является нахождение оптимальной стратегии принятия решений агентом в заданной среде. Агент старается максимизировать суммарную награду, получаемую за принятие последовательности действий.

Для достижения этой цели агент исследует среду, выбирая действия и получая от нее обратную связь в виде подкрепления. Он обучается на основе этой обратной связи, модифицируя свою стратегию и адаптируясь к изменениям в окружающей среде.

Обучение с подкреплением является мощным инструментом для решения задач, в которых необходимо принимать последовательность действий в динамической среде. Оно находит широкое применение в таких областях, как управление роботами, игры, финансы, биология и другие.

Принципы обучения с подкреплением

Принципы обучения с подкреплением включают следующие ключевые элементы:

1. Агент: агент представляет собой систему или программу, способную взаимодействовать с окружающей средой и принимать решения. Он обладает определенным состоянием и может выполнять действия.

2. Окружающая среда: это внешний мир, в котором действует агент. Она также включает в себя все возможные состояния, в которых может находиться система, и допустимые действия, которые может совершать агент.

3. Состояние: состояние – это описание текущего положения агента в окружающей среде. Оно может быть полностью наблюдаемым или неполностью наблюдаемым, в зависимости от доступности информации о состоянии системы.

4. Действие: действие – это выбор агентом определенного варианта действия из всех возможных вариантов. Задача агента состоит в том, чтобы выбрать наилучшее действие с учетом текущего состояния и полученных ранее наград.

5. Награда: награда или штраф – это численный сигнал, который агент получает от среды в ответ на его действие. Награда обычно является целью агента и определяет качество выполняемой им работы.

Обучение с подкреплением стремится обучить агента оптимальной стратегии действий, которая позволит ему максимизировать суммарную награду в долгосрочной перспективе.

Принципы обучения с подкреплением стали основой для создания различных систем и алгоритмов, способных решать сложные задачи в автономном режиме, например, в управлении роботами, играх, финансовых приложениях и других областях.

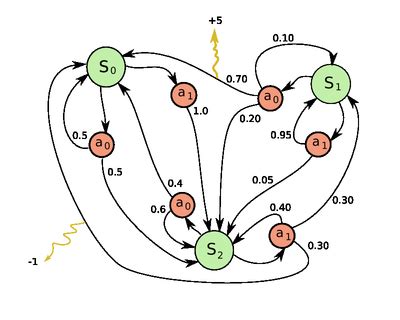

Марковский процесс принятия решений

Процесс состоит из следующих основных компонентов:

- Состояния (States): это набор возможных состояний, в которых может находиться агент. Например, в игре на шахматной доске состоянием может быть расположение каждой фигуры.

- Действия (Actions): это набор возможных действий, которые агент может предпринять в каждом состоянии. Например, в игре на шахматной доске действием может быть перемещение фигуры на определенное поле.

- Вероятности перехода (Transition Probabilities): это вероятности перехода из одного состояния в другое при осуществлении определенного действия. Например, вероятность перемещения фигуры на соседнее поле может быть выше, чем вероятность остаться на текущем поле.

- Функция вознаграждения (Reward Function): это функция, определяющая вознаграждение, которое агент получает за каждое действие или состояние. Например, перемещение фигуры на поле, где находится фигура противника, может привести к большему вознаграждению, чем перемещение на пустое поле.

- Политика (Policy): это стратегия, определяющая, какое действие должен предпринять агент в каждом состоянии. Например, агент может выбирать действие с наибольшим ожидаемым вознаграждением.

MDP позволяет моделировать сложные сценарии и находить оптимальную стратегию, максимизирующую суммарное вознаграждение. Эта модель нашла применение в различных областях, таких как робототехника, финансовая математика и искусственный интеллект. Примером применения MDP может быть обучение игре в шахматы, где агент должен принимать решения на каждом шаге, учитывая текущее состояние игровой доски и возможные переходы.

Постановка задачи обучения с подкреплением

Определение задачи обучения с подкреплением требует формализации ключевых элементов:

1. Состояния (States) – это описание окружающей среды в конкретный момент времени. Агент взаимодействует с средой, переходя между состояниями.

2. Действия (Actions) – это набор возможных действий, которые агент может совершать в каждом состоянии. Агент выбирает действие на основе текущего состояния и стремится выбрать оптимальные действия, которые приведут к максимальному вознаграждению.

3. Правила перехода (Transition Rules) – это функция, которая определяет, как состояние среды изменяется в результате выполнения действия агента. Она связывает текущее состояние, действие агента и следующие состояние.

4. Функция вознаграждения (Reward Function) – это функция, которая определяет вознаграждение, получаемое агентом в каждом состоянии после выполнения действия. Часто целью агента является максимизация кумулятивного вознаграждения в течение всего процесса взаимодействия.

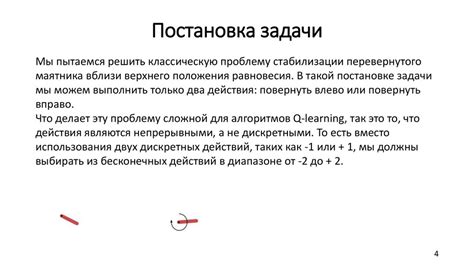

Целью обучения с подкреплением является выработка стратегии, которая позволит агенту выбирать оптимальные действия в каждом состоянии среды, чтобы максимизировать получаемое вознаграждение. Для достижения этой цели применяются различные алгоритмы и методы, такие как Q-обучение, метод Монте-Карло, методы градиентного спуска и т.д.

Обучение с подкреплением находит применение в различных областях, включая робототехнику, управление процессами, финансовые рынки и игровую индустрию. Примерами задач обучения с подкреплением могут быть обучение робота ходить, обучение компьютерной программы играть в шахматы или обучение агента виртуальной среды преодолевать препятствия.

| Состояние | Действие | Следующее состояние | Вознаграждение |

|---|---|---|---|

| Состояние 1 | Действие 1 | Состояние 2 | 0.5 |

| Состояние 2 | Действие 2 | Состояние 3 | -1.0 |

В данной таблице показан пример формализации задачи обучения с подкреплением. На каждом шаге агент находится в определенном состоянии и выбирает действие, в результате которого он переходит в следующее состояние и получает определенное вознаграждение. Целью агента является максимизация общего вознаграждения, что может потребовать выбора оптимальных действий или исследование новых вариантов взаимодействия с окружающей средой.

Примеры применения обучения с подкреплением

Обучение с подкреплением применяется в различных областях и сферах деятельности, включая робототехнику, игровую индустрию, управление системами и др. Рассмотрим несколько примеров использования данной техники:

| Область применения | Описание примера |

|---|---|

| Робототехника | Обучение роботов выполнять определенные задачи, такие как перемещение объектов, навигация в неизвестной среде или выполнение сложных манипуляций. Роботу предоставляется возможность экспериментировать и получать обратную связь от окружающей среды для нахождения наиболее оптимальных действий. |

| Игровая индустрия | Использование обучения с подкреплением для создания компьютерных игр с усовершенствованным искусственным интеллектом. Алгоритмы машинного обучения могут обучаться игре на основе подкрепления от игрока или других источников информации, что позволяет создавать более умных и адаптивных персонажей и оптимизировать игровой процесс. |

| Управление системами | Обучение автоматических систем управления, таких как автопилоты или умные дома, на основе обратной связи и подкрепления от окружающей среды. Это позволяет системам принимать решения и выполнять действия, оптимизирующие их работу и удовлетворяющие потребности пользователей. |

Это лишь некоторые примеры применения обучения с подкреплением. В современном мире эта техника находит все большее применение и открывает новые возможности для решения сложных задач и создания умных систем.

Автономные автомобили

Одна из самых актуальных областей, в которых применяется обучение с подкреплением, это разработка автономных автомобилей. В основе работы таких автомобилей лежит использование искусственных нейронных сетей, которые обучаются на большом объеме данных об окружающей среде и правилах дорожного движения.

Автомобиль непрерывно получает информацию с помощью различных датчиков, таких как радары, лидары и камеры. Эта информация подается на вход нейронной сети, которая анализирует ее и принимает решение о дальнейших действиях.

Во время обучения нейронной сети автомобиля запускают в виртуальной среде, где она обучается на основе большого количества различных ситуаций на дороге. Алгоритмы обучения с подкреплением позволяют автомобилю изучать как негативные, так и позитивные последствия своих действий.

Подобные системы обучения позволяют автомобилю оперативно реагировать на меняющуюся дорожную обстановку, предсказывать дорожные ситуации и принимать безопасные решения. Разработка и совершенствование таких систем ставит перед исследователями множество технических, этических и правовых задач.

Робототехника

Главной целью робототехники является разработка устройств, способных выполнять различные задачи, которые ранее могли быть выполнены только человеком. Роботы могут быть использованы в различных областях, таких как производство, медицина, авиация, космос и даже в быту.

Обучение с подкреплением является одним из методов обучения роботов. В этом подходе робот получает информацию о своем окружении и обучается принимать решения на основе полученных данных и желаемых результатов. С помощью обратной связи, робот адаптирует свое поведение и постепенно улучшает свои навыки.

Примером обучения с подкреплением в робототехнике является процесс обучения робота игре в шахматы. Роботу предоставляется информация о текущем состоянии шахматной доски и основные правила игры. Робот, используя алгоритмы обучения с подкреплением, играет несколько партий и анализирует их результаты. Со временем робот научится принимать лучшие решения и станет сильным игроком.

Робототехника и обучение с подкреплением сегодня активно развиваются и находят применение во многих сферах жизни. Они позволяют создавать умные и эффективные решения, помогающие справиться с различными задачами и улучшить качество жизни.