В современном информационном обществе огромное количество данных создается, передается и хранится каждый день. Большие объемы информации стали привычным явлением, и теперь компьютерам приходится тяжело спасаться от перегрузки. Почему же нынешние технологии не справляются с таким потоком данных?

Одним из основных причин огромного количества данных является все большее участие людей в цифровой сфере. Ведь мы все активно пользуемся интернетом, социальными сетями, мессенджерами, онлайн-магазинами и прочими сервисами. Все это создает большое количество информации, которую необходимо обрабатывать и хранить.

Кроме того, с каждым годом увеличивается количество устройств, подключенных к интернету. Умные телефоны, планшеты, ноутбуки, домашние технологии - все это генерирует большое количество данных, которые отправляются в облачные сервисы и серверы для обработки и хранения. Старые алгоритмы и аппаратные решения не всегда способны справиться с таким потоком информации.

Возрастающий объем данных: компьютеры сталкиваются с проблемой перегрузки

Современный мир пронизан взаимосвязью с технологиями, которые с каждым днем становятся все более важными для нашей жизни. В работе, образовании, развлечениях и коммуникации мы все больше полагаемся на технические устройства, такие как компьютеры.

Однако, с ростом объема данных, которые мы генерируем и используем, возникает проблема перегрузки компьютеров. Для того чтобы осуществлять все необходимые операции, нам требуется все больше вычислительной мощности и памяти.

Огромное количество данных, таких как тексты, изображения, видео, аудио, их обработка и хранение занимают все больше пространства и требуют больше времени для обработки. Программы и приложения, которые мы используем, становятся все сложнее и требуют более мощных компьютеров для своей работы.

Одним из путей решения проблемы перегрузки компьютеров является улучшение аппаратной части: установка более быстрых процессоров, увеличение объема оперативной памяти, быстрых жестких дисков и т.д. Однако, это путь требует значительных финансовых затрат и его эффективность ограничена.

Вторым путем решения проблемы перегрузки компьютеров является оптимизация и улучшение программного обеспечения. Это может быть оптимизация алгоритмов работы программ, компрессия данных для уменьшения их объема, распределенные системы хранения и обработки данных и другие методы.

Однако, независимо от принятых мер, возрастающий объем данных постоянно представляет вызов для компьютеров и инженеров. Будущее компьютеров связано с разработкой новых технологий, которые могут справиться с гигантским объемом данных и обеспечить эффективную работу в условиях постоянного роста информационного общества.

Необходимость обработки огромного объема данных

В современном мире объемы данных постоянно растут, и компьютерам приходится работать с большим количеством информации. Обработка такого огромного объема данных становится все более актуальной задачей.

Существует несколько основных причин, по которым необходимо обрабатывать большие объемы данных. Во-первых, огромное количество данных часто содержит ценную информацию, которую можно использовать для принятия важных решений. Например, анализ больших данных может помочь компаниям определить предпочтения своих клиентов и разработать более эффективную стратегию маркетинга.

Во-вторых, обработка больших объемов данных позволяет выявить скрытые закономерности и тенденции. Изучение больших данных может помочь исследователям в различных областях науки обнаружить новые связи или осуществить прогнозирование будущих событий.

Также, обработка огромного объема данных требуется при работе с сенсорными системами и Интернетом вещей. Например, с помощью анализа больших данных можно эффективно управлять потоками информации от различных устройств, что позволяет повысить эффективность и безопасность различных систем.

В целом, обработка огромного объема данных является неотъемлемой частью современной вычислительной обработки. Эта задача становится все более важной с каждым годом, и разработчики постоянно ищут новые способы эффективной работы с большими объемами информации.

Изменение требований к вычислительной мощности

В современном мире количество данных, которые нужно обрабатывать, достигло огромных масштабов. Это обусловлено развитием различных технологий, таких как Интернет вещей, искусственный интеллект, большие данные и другие. Старые компьютеры и серверы не могут справиться с объемом информации, с которым приходится работать сегодня.

В связи с этим, требования к вычислительной мощности значительно изменились. Простые процессоры и небольшое количество оперативной памяти уже недостаточны для эффективной работы с данными. Современные системы должны быть оснащены мощными многоядерными процессорами, большим объемом оперативной памяти и высокоскоростными жесткими дисками для обработки и хранения большого количества информации.

Большие объемы данных также требуют эффективных алгоритмов и программного обеспечения, способного работать с ними. Разработчикам и инженерам приходится создавать новые алгоритмы и оптимизировать программы, чтобы они максимально эффективно использовали ресурсы компьютера.

Изменение требований к вычислительной мощности также привело к развитию облачных вычислений. Облачные платформы позволяют распределять вычислительные ресурсы между множеством серверов, что позволяет эффективно обрабатывать огромное количество данных.

С учетом этих изменений, разработчикам и компаниям приходится инвестировать в обновление и модернизацию своей вычислительной инфраструктуры. Это может включать в себя покупку новых серверов, использование облачных услуг или создание собственных вычислительных центров для обработки данных.

В целом, изменение требований к вычислительной мощности является неотъемлемой частью развития технологий и обработки больших данных. Компьютеры и серверы должны постоянно адаптироваться и развиваться, чтобы справиться с растущим объемом информации и обеспечить эффективную работу с данными.

Возникновение современных технологий для обработки данных

С развитием технологий и ростом количества данных, стало ясно, что традиционные способы обработки и анализа информации не могут справиться с таким объемом. Для эффективной работы с огромными массивами данных были разработаны современные технологии, которые позволяют быстро и точно обрабатывать информацию.

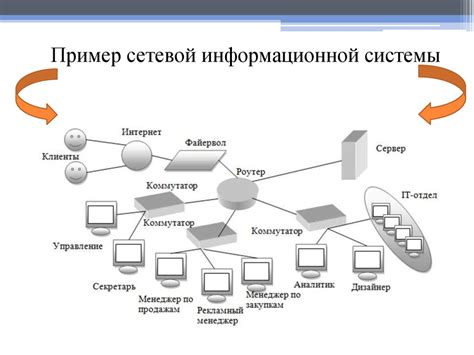

Одной из таких технологий является распределенная обработка данных. Она основана на использовании кластеров компьютеров, которые работают параллельно, обрабатывая различные части данных. Это позволяет существенно ускорить процесс обработки и анализа информации, так как каждый компьютер в кластере выполняет свою часть работы.

Другой важной технологией является облачные вычисления. Они позволяют обрабатывать данные удаленно, хранить их на серверах в облаке и получать доступ к информации через интернет. Облачные вычисления предоставляют бесконечные ресурсы для обработки данных и позволяют масштабировать систему в зависимости от потребностей.

Также была разработана технология Big Data, которая позволяет хранить и анализировать огромные объемы разнородных данных. Она основана на использовании специализированных баз данных, алгоритмов обработки и анализа информации. Технология Big Data позволяет выявлять новые закономерности и тенденции, а также прогнозировать будущие события на основе имеющихся данных.

| Технология | Особенности |

|---|---|

| Распределенная обработка данных | Параллельная работа компьютеров |

| Облачные вычисления | Удаленная обработка данных |

| Big Data | Обработка огромных данных |

Рост сложности алгоритмов обработки данных

С постоянным увеличением объема доступной информации современным компьютерам становится все сложнее справляться с обработкой данных и выполнением сложных алгоритмов. Растущее количество информации порождает новые вызовы и требует постоянного поиска эффективных способов ее обработки.

Одним из основных проблемных моментов является рост объема данных, с которыми необходимо работать. Для компьютеров, не обладающих достаточными вычислительными мощностями, реализация сложных алгоритмов может стать непосильной задачей. Процессору может потребоваться слишком много времени на расчеты, хранение данных может оказаться сложной задачей из-за нехватки оперативной памяти, а доступ к информации может затрудняться из-за неправильной структуры хранения или перегруженности сети.

В условиях растущего объема данных необходимо постоянно совершенствовать алгоритмы обработки информации, чтобы найти наиболее оптимальное решение для выполнения задач. От новых алгоритмов требуется не только скорость выполнения, но и эффективность использования ресурсов. Такие алгоритмы могут учитывать особенности структуры данных и оперировать информацией более эффективно, сокращая время выполнения задач и снижая нагрузку на систему. Они также способны адаптироваться к изменению объема данных, автоматически меняя свою структуру и алгоритмы работы.

Рост сложности алгоритмов обработки данных является естественным результатом постоянного развития информационных технологий и возрастающей потребности в обработке больших объемов информации. Однако, разработчики постоянно стремятся сокращать негативные последствия этого роста, предлагая новые эффективные алгоритмы, проекты и решения, чтобы компьютеры могли успешно справляться с обработкой и анализом данных в современном информационном мире.

Проблемы недостаточных ресурсов для обработки данных

Во-первых, нехватка оперативной памяти может значительно затруднить обработку данных. Когда компьютер обрабатывает большие объемы информации, требуется большое количество памяти для хранения промежуточных результатов и данных. Если оперативной памяти недостаточно, компьютер начинает использовать виртуальную память, что снижает производительность и замедляет работу системы.

Во-вторых, ограничения процессора могут привести к недостаточным ресурсам для обработки данных. Если процессор слишком слабый или устаревший, он может не справиться с большой нагрузкой и замедлить обработку данных. Кроме того, многие программы требуют многопоточности для оптимальной обработки данных, и если процессор не поддерживает данную функциональность, это также может привести к проблемам.

В-третьих, ограничения дискового пространства могут создавать проблемы при обработке данных. Если на компьютере недостаточно места для хранения данных или если диск, на котором хранятся данные, имеет низкую скорость чтения и записи, обработка данных может быть сильно замедлена.

Наконец, недостаточно мощная графическая карта также может оказывать влияние на процесс обработки данных. Некоторые задачи, связанные с обработкой данных, могут требовать высокой производительности графической карты, и если она недостаточно мощная, это может привести к проблемам и снижению производительности.

В целом, проблемы недостаточных ресурсов для обработки данных могут значительно затруднить работу компьютера. Чтобы предотвратить возникновение таких проблем, важно регулярно обновлять компьютерное оборудование и обеспечивать достаточные ресурсы для обработки данных.

Решения для оптимизации обработки данных

С ростом объема данных компьютерам становится все сложнее справляться с нагрузкой, поэтому необходимы специальные решения, позволяющие оптимизировать процесс и ускорить обработку информации.

Во-первых, одним из подходов к оптимизации работы с данными является использование распределенных систем. Такие системы позволяют распределить нагрузку на несколько компьютеров, что увеличивает скорость обработки и снижает риск перегрузки.

Во-вторых, необходимо использовать специализированные алгоритмы и структуры данных. Например, хэш-таблицы, деревья поиска и графы позволяют эффективно хранить и обрабатывать большие объемы информации.

Для ускорения обработки данных также можно применить параллельное программирование. Это позволяет выполнять несколько задач одновременно, что значительно увеличивает производительность.

Помимо этого, важно регулярно проводить оптимизацию и профилирование кода. Это позволяет выявить узкие места и провести оптимизацию, что повысит эффективность обработки данных.

Будущее обработки огромных данных

С развитием технологий и постоянным увеличением объема данных, обработка огромных массивов информации становится все более актуальной задачей. В будущем ожидается значительное развитие и улучшение средств и методов обработки огромных данных.

Машинное обучение и искусственный интеллект будут играть ключевую роль в обработке огромных данных. С развитием алгоритмов и улучшением аппаратной части, компьютеры будут способны эффективно анализировать и извлекать ценную информацию из огромных объемов данных.

Одной из перспективных областей становится облачные вычисления. Это позволяет обрабатывать и хранить данные удаленно, что делает процесс обработки более гибким и масштабируемым. Большое количество мощных серверов и высокоскоростные сети обеспечат быстрый доступ к данным и ускорят процесс анализа.

Распределенные системы обработки данных также будут востребованы в будущем. Кластеры компьютеров будут работать вместе, чтобы обрабатывать данные параллельно и повышать эффективность обработки. Каждый компьютер будет обрабатывать свою часть данных, а затем объединять результаты.

Интеграция всех этих технологий позволит решать сложные задачи и находить скрытые закономерности в огромных объемах данных. Использование новых методов обработки и анализа огромных данных станет неотъемлемой частью современного мира, и эта тенденция только усилится в будущем.