Python является одним из наиболее популярных языков программирования в сфере анализа данных и машинного обучения. Одной из основных задач при работе с данными является создание dataset – набора данных, представляющего собой таблицу с различными признаками и метками, которые могут быть использованы для обучения моделей или проведения анализа данных.

В этой статье мы рассмотрим подробное руководство по созданию dataset в Python. Мы разберем различные способы создания dataset, включая использование встроенных функций Python, работы с внешними источниками данных, а также обработку и очистку данных перед созданием dataset.

Будут рассмотрены следующие важные темы, связанные с созданием dataset: сбор и загрузка данных, разделение данных на тренировочный и тестовый наборы, обработка пропущенных значений, кодирование категориальных переменных и нормализация данных. Мы также рассмотрим способы визуализации и исследовательского анализа данных, которые могут помочь в создании dataset и понимании характеристик данных.

Создание dataset в Python: базовые понятия

Один из основных способов создания dataset в Python - это использование библиотеки pandas. Pandas предоставляет удобные инструменты для чтения и записи данных в различных форматах, таких как CSV, Excel, SQL, JSON, и других.

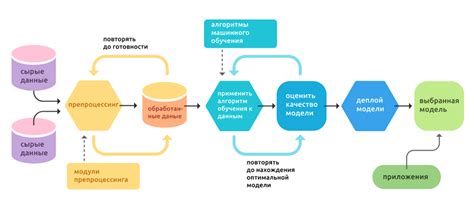

Процесс создания dataset с использованием pandas обычно включает следующие шаги:

- Загрузка данных из источника, такого как файл CSV или база данных.

- Очистка и предобработка данных. Это может включать удаление дубликатов, заполнение пропущенных значений, преобразование типов данных и т.д.

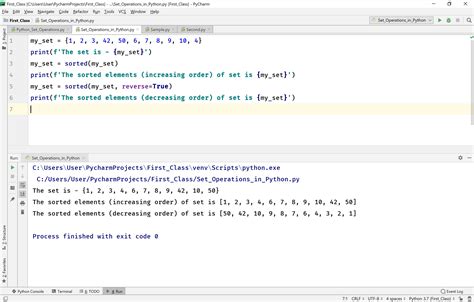

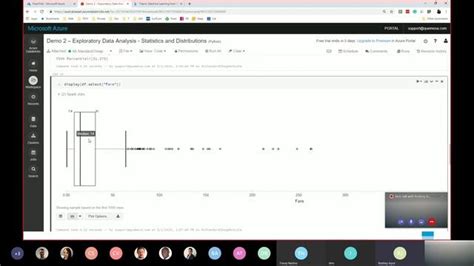

- Исследовательский анализ данных (EDA). В этом шаге вы можете изучить статистику данных, построить графики и визуализации для более глубокого понимания данных.

- Преобразование данных. Это может включать шкалирование признаков, кодирование категориальных переменных, разделение данных на обучающую и тестовую выборки и т.д.

После завершения всех этих шагов, вы получите готовый dataset, который можно использовать для обучения модели машинного обучения или анализа данных.

Знание базовых понятий и процессов создания dataset в Python поможет вам успешно работать с данными и достичь хороших результатов в анализе данных и машинном обучении.

Основные инструменты для работы с dataset в Python

| Библиотека | Описание |

|---|---|

| pandas | pandas – мощная библиотека для анализа и манипуляций с данными. Она предоставляет удобные структуры данных, такие как DataFrame, которые позволяют работать с таблицами и выполнять разнообразные операции над данными. |

| NumPy | NumPy – библиотека для работы с многомерными массивами и матрицами чисел. Она предоставляет возможности по выполнению математических операций, агрегаций, фильтрации и преобразования данных. |

| scikit-learn | scikit-learn – библиотека для машинного обучения в Python. Она предоставляет множество инструментов для обработки данных, создания моделей и их обучения. |

| Matplotlib | Matplotlib – библиотека для визуализации данных. Она позволяет создавать разнообразные графики, диаграммы и карты для наглядного представления результатов анализа. |

| Seaborn | Seaborn – библиотека для визуализации статистических данных. Она предоставляет более высокоуровневые функции и стили, с помощью которых можно быстро создавать красивые и информативные графики. |

Эти инструменты являются широко используемыми в анализе данных с помощью Python и позволяют упростить и ускорить работу с dataset'ами. Каждая из них имеет свои особенности и набор функций, поэтому выбор инструментов зависит от конкретных задач и требований проекта.

Первичная обработка данных в dataset: удаление дубликатов и пропущенных значений

Удаление дубликатов данных является неотъемлемой частью первичной обработки. Дубликаты могут быть нежелательными, так как они могут приводить к искажению результатов и снижать точность анализа. Для удаления дубликатов данных в датасете можно использовать метод drop_duplicates().

Пропущенные значения в данных могут возникать по разным причинам, например, из-за ошибок ввода, некорректных значений или неполного сбора данных. Обработка пропущенных значений является важным этапом первичной обработки данных. В Pandas пропущенные значения представлены как NaN (не число) или None, и их можно обрабатывать различными способами.

Один из способов обработки пропущенных значений - удаление строк или столбцов, содержащих пропущенные значения, с помощью метода dropna(). Другой способ - заполнение пропущенных значений с помощью метода fillna(). Например, можно заполнить пропущенные значения средним значением столбца или наиболее часто встречающимся значением.

После удаления дубликатов и обработки пропущенных значений, датасет будет готов для более детального анализа и работы с данными.

| Метод | Описание |

|---|---|

drop_duplicates() | Удаляет дубликаты данных в датасете. |

dropna() | Удаляет строки или столбцы, содержащие пропущенные значения. |

fillna() | Заполняет пропущенные значения заданным значением или средним значением столбца. |

Обработка категориальных и числовых переменных в dataset

При работе с dataset-ом, часто возникает необходимость обработки категориальных и числовых переменных. В этом разделе мы рассмотрим методы работы с этими типами данных в Python.

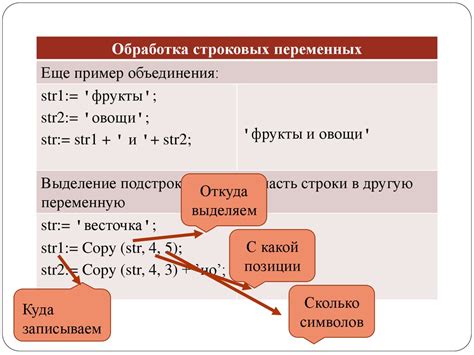

Обработка категориальных переменных

Категориальные переменные представляют собой данные, которые принимают определенное количество дискретных значений. Для обработки таких переменных можно использовать различные подходы:

- Кодирование значением (Label Encoding): при этом каждому уникальному значению присваивается свой уникальный код. Этот подход подходит, когда значения имеют отношение порядка, например, "низкий", "средний", "высокий".

- Кодирование с помощью One-Hot (Dummy Encoding): при использовании этого метода каждому уникальному значению присваивается новый столбец, где 1 указывает на присутствие значения, а 0 - на его отсутствие. Этот подход подходит, когда значения не имеют отношения порядка.

Обработка числовых переменных

Числовые переменные представляют собой данные, которые имеют непрерывный или дискретный характер. Для обработки таких переменных можно использовать следующие методы:

- Масштабирование (Scaling): при этом значения переменных масштабируются таким образом, чтобы они находились в определенном диапазоне. Например, можно использовать метод Min-Max Scaling, где значения масштабируются в интервале от 0 до 1.

- Нормализация (Normalization): при использовании этого метода значения переменных масштабируются таким образом, чтобы они имели среднее значение 0 и стандартное отклонение 1. Такой подход удобен при работе с алгоритмами, которые применяют расстояния или сходство между значениями, например, кластеризацией или методом ближайших соседей.

Обработка категориальных и числовых переменных является важным этапом при подготовке данных для анализа или построения моделей машинного обучения. Выбор подхода зависит от особенностей данных и задачи, которую необходимо решить.

Преобразование данных: масштабирование и нормализация

Масштабирование данных происходит путем изменения масштаба значений признаков. Обычно это делается для приведения всех признаков к одному диапазону, например, от 0 до 1 или от -1 до 1. Такой подход позволяет избежать смещения весов между признаками, которое может возникнуть в случае, если значения признаков сильно отличаются по масштабу. Наиболее распространенными методами масштабирования являются мин-макс масштабирование и стандартизация.

Мин-макс масштабирование преобразует значения признаков в диапазон от 0 до 1. Формула для вычисления масштабированных значений выглядит следующим образом:

- min_max_scaled = (x - min_x) / (max_x - min_x)

где x - это исходное значение признака, min_x и max_x - соответственно минимальное и максимальное значения признака в датасете.

Стандартизация, на другой стороне, преобразует значения признаков таким образом, чтобы они имели среднее значение 0 и стандартное отклонение 1. Формула для стандартизации:

- standardized = (x - mean) / std

где x - это исходное значение признака, mean - среднее значение признака, std - стандартное отклонение признака в датасете.

Процесс нормализации данных позволяет привести все значения признаков к диапазону от 0 до 1. Нормализация производится путем преобразования исходных значений с использованием формулы:

- normalized = (x - min_x) / (max_x - min_x)

где x - это исходное значение признака, min_x и max_x - соответственно минимальное и максимальное значения признака в датасете.

Использование масштабирования и нормализации данных позволяет подготовить датасет к работе с алгоритмами машинного обучения и повысить точность результатов. Выбор метода зависит от конкретной задачи и характера данных, поэтому важно экспериментировать с разными методами и выбрать наиболее подходящий.

Создание новых признаков и фичей для dataset

Для создания новых признаков в Python можно воспользоваться множеством инструментов и библиотек. Начать можно с простых математических операций, таких как сложение, вычитание, умножение, деление и возведение в степень. Также можно использовать математические функции, такие как синус, косинус, тангенс, логарифм, экспонента и многое другое.

Другой способ создания новых признаков - агрегирование информации из разных столбцов или признаков. Например, можно сложить значения двух столбцов или вычислить среднее значение по группе данных. Этот подход может быть особенно полезен при работе с табличными данными.

Также стоит обратить внимание на преобразование категориальных признаков в числовые. Это можно сделать с помощью различных методов, таких как кодирование One-Hot, кодирование метками или порядковое кодирование. Это позволит использовать категориальные данные в моделях машинного обучения, которые работают только с числовыми данными.

Наконец, стоит упомянуть о возможности добавления внешних данных или дополнительных ресурсов для создания новых признаков. Например, можно использовать географические координаты для вычисления расстояний или временные ряды для выделения трендов и сезонных закономерностей.

Создание новых признаков требует креативности и экспериментов. Часто необходимо провести несколько итераций, чтобы найти наиболее полезные и информативные признаки. Однако, правильно подобранные новые признаки могут значительно улучшить качество и результаты анализа данных.

Экспорт и импорт dataset в различных форматах

При работе с dataset в Python возникает необходимость экспортировать данные в различные форматы или импортировать их из внешних источников. В этом разделе мы рассмотрим, как выполнить экспорт и импорт dataset в разных форматах.

Один из самых популярных форматов для экспорта данных из dataset - это CSV (Comma Separated Values). CSV-файл представляет собой текстовый файл, в котором значения разных полей разделены запятыми. Для экспорта dataset в формат CSV в Python можно использовать метод to_csv().

import pandas as pd

# Создание dataset

dataset = pd.DataFrame({'Имя': ['Алиса', 'Боб', 'Клэр'],

'Возраст': [25, 30, 35]})

# Экспорт dataset в CSV-файл

dataset.to_csv('dataset.csv', index=False)

Таким образом, мы сохранили dataset в файле dataset.csv. Установка параметра index=False исключит запись индексов строк в файл.

Кроме CSV, в Python можно экспортировать dataset в другие форматы, такие как Excel, JSON, SQL и другие. Для экспорта в формат Excel можно использовать метод to_excel(), а для экспорта в формат JSON - to_json().

Для импорта данных из внешних источников в dataset также существуют соответствующие методы. Например, для импорта данных из CSV-файла в dataset можно использовать метод read_csv().

import pandas as pd

# Импорт данных из CSV-файла в dataset

dataset = pd.read_csv('dataset.csv')

Таким образом, мы импортировали данные из файла dataset.csv в dataset.

Помимо импорта данных из CSV, в Python можно импортировать данные из различных источников, например, из Excel-файла, JSON-файла, SQL-базы данных и других форматов. Для импорта из формата Excel можно использовать метод read_excel(), а для импорта из формата JSON - read_json().

Экспорт и импорт dataset в различных форматах являются важным этапом при работе с данными в Python. Знание методов экспорта и импорта позволяет обмениваться данными между разными системами и форматами, а также сохранять и восстанавливать данные для последующего анализа и обработки.