Python - это один из наиболее популярных языков программирования, который широко используется для создания веб-приложений, скриптов, системного администрирования и многих других областей. Одной из ключевых функций при работе с веб-приложениями является переход по ссылкам. В данной статье рассмотрим, как реализовать эту функцию с помощью Python.

Переход по ссылке - это процесс, при котором пользователь нажимает на гипертекстовую ссылку и переходит на новую веб-страницу или страницу внутри текущего сайта. Для реализации данной функции в Python мы можем использовать различные библиотеки, такие как Requests, urllib и Selenium. Каждая из этих библиотек имеет свои особенности и подходит для разных сценариев использования.

Requests - это одна из самых популярных библиотек Python, которая облегчает выполнение HTTP-запросов. Она позволяет с лёгкостью переходить по ссылкам, отправлять GET и POST запросы, обрабатывать cookies и многое другое. Пример реализации перехода по ссылке с использованием библиотеки Requests может выглядеть следующим образом:

import requests

response = requests.get('https://www.example.com') Как видно из примера, мы отправляем GET запрос на указанный URL и сохраняем ответ от сервера в переменную "response". Далее мы можем обрабатывать этот ответ по необходимости.

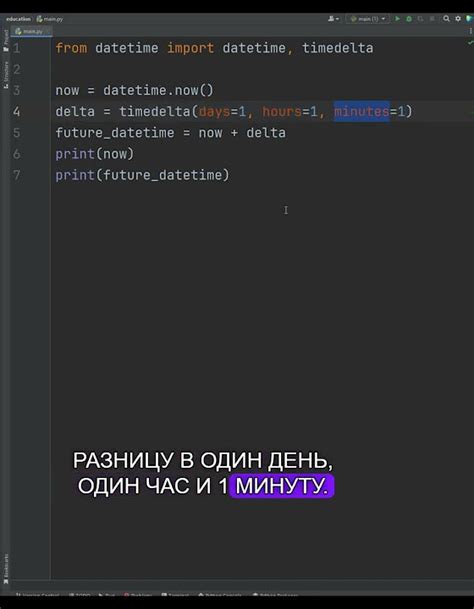

Также можно использовать библиотеку urllib для выполнения перехода по ссылке в Python. Она является частью стандартной библиотеки Python и предоставляет широкий набор функций для работы с URL-адресами. Реализация перехода по ссылке с использованием библиотеки urllib может выглядеть следующим образом:

import urllib.request

response = urllib.request.urlopen('https://www.example.com') Этот пример аналогичен предыдущему, однако здесь мы используем функцию "urlopen" для выполнения GET запроса на указанный URL.

И, наконец, библиотека Selenium является мощным инструментом для автоматизации действий веб-браузера. Она позволяет не только переходить по ссылкам, но и взаимодействовать с элементами страницы, заполнять формы, выполнять скрипты JavaScript и многое другое. Пример использования библиотеки Selenium для реализации перехода по ссылке может выглядеть так:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://www.example.com') В данном примере мы создаем объект webdriver для выбранного веб-браузера и выполняем переход по указанному URL с помощью метода "get".

Теперь вы знаете несколько способов реализации перехода по ссылке в Python с использованием различных библиотек. Выбор конкретного метода зависит от ваших задач и предпочтений. При выборе библиотеки следует учитывать такие факторы, как простота использования, возможности и производительность. Успехов в программировании!

Переход по ссылке в Python: основные методы и инструменты

Python предоставляет множество инструментов для реализации перехода по ссылкам. Вот несколько основных методов и функций, которые вы можете использовать:

urllib.request: модуль, который позволяет открывать URL-адреса и получать данные из них.beautifulsoup4: библиотека для извлечения данных из HTML и XML документов. С ее помощью вы можете извлечь ссылки из веб-страницы и перейти по ним.requests: библиотека, которая делает HTTP-запросы и позволяет получать содержимое веб-страницы.selenium: инструмент для автоматизации действий веб-браузера. С его помощью вы можете симулировать щелчок по ссылке и перейти на другую страницу.

При использовании этих инструментов важно помнить о следующих вещах:

- Не забудьте импортировать необходимые модули и библиотеки перед использованием.

- Убедитесь, что вы правильно понимаете структуру и код веб-страницы, чтобы найти нужные ссылки.

- Проверьте, что ссылка действительна и страница доступна перед переходом.

- Обработайте возможные ошибки и исключения, которые могут возникнуть при переходе по ссылке.

- Учтите, что некоторые сайты могут ограничивать автоматический доступ или делать его более сложным. В этом случае может потребоваться использовать дополнительные методы для перехода по ссылкам.

Все эти инструменты и методы позволяют вам эффективно реализовать переход по ссылкам в Python и извлечь нужные вам данные или выполнить определенные действия на веб-странице.

Переход по ссылке с использованием библиотеки Requests

Для реализации перехода по ссылке с использованием библиотеки Requests, необходимо выполнить следующие шаги:

- Установить библиотеку Requests. Это можно сделать с помощью менеджера пакетов Pip:

pip install requests

- Импортировать библиотеку в свой скрипт:

import requests

- Использовать метод

get()для отправки GET-запроса по указанному URL:

response = requests.get('http://example.com')

Вернувшийся объект response содержит ответ от сервера. Вы можете получить содержимое страницы, статус запроса и другие атрибуты, используя методы и свойства объекта response.

Например, чтобы получить содержимое HTML-страницы, можно использовать метод text:

html_content = response.text

Если требуется передать параметры в запросе, это можно сделать, добавив их в виде словаря в аргумент params метода get(). Например:

params = {'key1': 'value1', 'key2': 'value2'}

response = requests.get('http://example.com', params=params)

Это позволит добавить параметры к URL и получить данные, основанные на переданном запросе.

Использование библиотеки Requests позволяет легко и удобно выполнять переходы по ссылкам, получая данные с сервера. Она также предоставляет множество вспомогательных методов для работы с HTTP-заголовками, куками, аутентификацией и многими другими функциями.

Примечание: При использовании библиотеки Requests следует учитывать, что она является сторонней и может быть изменена или удалена в будущих версиях Python.

Использование Selenium для перехода по ссылке в Python

Для использования Selenium в Python, сначала необходимо установить Selenium WebDriver. Для этого можно использовать пакетный менеджер pip:

pip install selenium

После установки Selenium WebDriver, необходимо импортировать соответствующие модули в свой Python скрипт:

from selenium import webdriver from selenium.webdriver.common.keys import Keys

Для открытия веб-страницы в Selenium WebDriver, сначала нужно создать экземпляр объекта класса webdriver. Затем можно использовать метод get() и передать ему URL страницы:

browser = webdriver.Firefox() # Инициализация драйвера

browser.get("https://example.com") # Переход по ссылке

Чтобы перейти по ссылке на странице, можно использовать метод find_element_by_link_text(), чтобы найти ссылку по тексту, или find_element_by_partial_link_text(), чтобы найти ссылку по части текста. Затем можно использовать метод click(), чтобы нажать на ссылку:

link = browser.find_element_by_link_text("Read more") # Находим ссылку

link.click() # Нажимаем на ссылку

Для закрытия браузера можно использовать метод quit():

browser.quit() # Закрываем браузер

Использование Selenium позволяет автоматизировать переходы по ссылкам и выполнение других действий на веб-страницах в Python. Это особенно полезно для тестирования веб-приложений и сбора данных с веб-сайтов.

Пример перехода по ссылке с помощью библиотеки Pyppeteer

Библиотека Pyppeteer предоставляет удобные средства для автоматизации действий в браузере с использованием Headless Chrome. Она позволяет выполнить переход по ссылке и получить содержимое веб-страницы.

Для начала работы с Pyppeteer необходимо установить его с помощью pip:

pip install pyppeteerПосле установки библиотеки можно приступить к использованию. Вот простой пример кода:

import asyncio

from pyppeteer import launch

async def main():

browser = await launch()

page = await browser.newPage()

await page.goto('https://example.com')

content = await page.content()

print(content)

await browser.close()

asyncio.get_event_loop().run_until_complete(main())Кроме того, Pyppeteer предоставляет множество возможностей для управления браузером, таких как заполнение форм, клики по элементам, скриншоты страницы и многое другое.

Pyppeteer прекрасно подходит для автоматизации тестирования веб-приложений, сбора данных с веб-сайтов, парсинга и анализа информации и других задач, связанных с взаимодействием с браузером.

Реализация перехода средствами стандартной библиотеки Python

Модуль urllib предоставляет функции для работы с URL-адресами, включая возможность открытия и чтения содержимого web-страницы. Для реализации перехода по ссылке можно использовать функцию urllib.request.urlopen, которая открывает указанный URL-адрес:

import urllib.request

response = urllib.request.urlopen('http://example.com')

html = response.read()

print(html)

Библиотека urllib также предоставляет возможность работы с параметрами запроса и установки заголовков запроса. Это позволяет более гибко настраивать переход по ссылке:

import urllib.request

import urllib.parse

url = 'http://example.com'

params = {'param1': 'value1', 'param2': 'value2'}

headers = {'User-Agent': 'Mozilla/5.0'}

encoded_params = urllib.parse.urlencode(params).encode()

request = urllib.request.Request(url, data=encoded_params, headers=headers)

response = urllib.request.urlopen(request)

html = response.read()

print(html)

Использование стандартной библиотеки Python для реализации перехода по ссылке позволяет достичь гибкости и универсальности при работе с различными web-ресурсами.

Обход ссылок на веб-странице с помощью библиотеки Beautiful Soup

Для начала работы с Beautiful Soup, необходимо установить ее с помощью pip:

pip install beautifulsoup4После установки библиотеки, можно приступать к созданию парсера и обходу ссылок на веб-странице. Для этого сначала необходимо импортировать модуль:

from bs4 import BeautifulSoupЗатем, с использованием модуля requests, можно получить HTML-страницу следующим образом:

import requests

response = requests.get("https://example.com")

html = response.textТеперь, когда у нас есть HTML-код страницы, мы можем использовать Beautiful Soup для его парсинга и извлечения нужной информации. Примером может быть получение списка ссылок на странице:

soup = BeautifulSoup(html, 'lxml')

links = soup.find_all('a')

for link in links:

print(link.get('href'))Получив список ссылок, можно использовать их для обхода других веб-страниц. Например, можно рекурсивно применить код обхода ссылок к каждой из найденных страниц, чтобы продолжить сбор информации.

Также, Beautiful Soup предоставляет возможность фильтровать ссылки по различным критериям. Например, можно выбрать только ссылки на веб-страницы с определенным доменом:

for link in links:

if link.get('href').startswith('https://example.com'):

print(link.get('href'))Использование Beautiful Soup для обхода ссылок на веб-странице позволяет автоматизировать получение и анализ информации со множества страниц, что может быть полезным при разработке веб-скрейперов, парсеров и других приложений, связанных с обработкой данных из Интернета.

Использование библиотеки Scrapy для автоматического перехода по ссылкам

Для использования Scrapy необходимо установить его с помощью менеджера пакетов Python pip:

pip install scrapyПосле успешной установки можно создать новый проект Scrapy с помощью команды:

scrapy startproject myprojectБиблиотека Scrapy позволяет легко определить модель данных, которая будет использоваться для хранения собранных данных. За счет этого обеспечивается удобный доступ к извлеченным данным и их последующая обработка.

Следующим шагом является создание "паука" - класса, который определяет поведение приложения при извлечении данных и переходе по ссылкам. Для этого необходимо создать новый файл внутри проекта и определить класс, который будет унаследован от базового класса Spider. Внутри класса нужно указать набор правил, которые будут использоваться для навигации по сайту и извлечения данных.

Пример использования Scrapy для автоматического перехода по ссылкам:

import scrapy

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['http://example.com']

def parse(self, response):

# Извлечение данных

data = response.css('div.content').extract()

# Обработка данных

# Переход по ссылкам

links = response.css('a::attr(href)').extract()

for link in links:

yield response.follow(link, self.parse)

В данном примере создается новый паук с именем "myspider". При запуске паука, он начнет с посещения указанного URL-адреса. Затем он будет извлекать данные из элемента div с классом "content" и обрабатывать их. После этого паук перейдет по всем ссылкам, которые найдет на странице и вызовет метод parse для каждой из них.

Scrapy позволяет использовать различные селекторы для точного определения элементов на странице, из которых необходимо извлечь данные. Он также поддерживает обработку AJAX-запросов и работу с пагинацией, что делает его мощным инструментом для сбора данных с веб-сайтов.

Использование библиотеки Scrapy для автоматического перехода по ссылкам значительно упрощает процесс сбора данных. Благодаря его удобному API и множеству встроенных функций, Scrapy является одним из наиболее популярных инструментов для сбора данных в мире Python.