Измерения являются неотъемлемой частью нашей жизни. Они позволяют нам оценить размеры, вес, время и другие характеристики объектов и процессов. Однако ни одно измерение не бывает полностью точным. Всегда существует определенная степень отклонения от истинного значения, которую мы называем погрешностью.

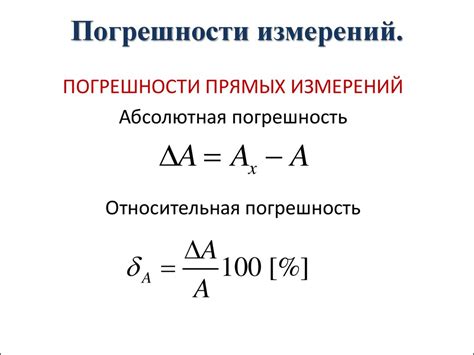

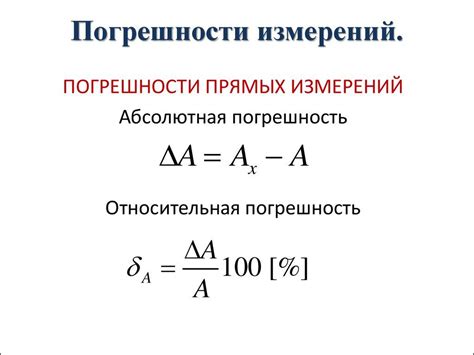

Абсолютная погрешность измерения - это численное значение, которое показывает насколько максимально может отличаться результат измерения от его истинного значения. Обычно абсолютная погрешность выражается в тех же единицах, что и само измеряемое значение. Например, если мы измеряем длину объекта и получаем результат 10 метров с абсолютной погрешностью 0,1 метра, то это означает, что длина объекта находится в диапазоне от 9,9 до 10,1 метра.

Относительная погрешность измерения - это отношение абсолютной погрешности к самому измеряемому значению, умноженное на 100%. Она показывает, насколько велика погрешность в процентном соотношении к измеряемому значению. Например, если мы измеряем силу и получаем результат 50 Н с относительной погрешностью 2%, то это означает, что измеренная сила может расходиться от истинной величины на 2% от 50 Н, то есть на 1 Н.

Определение абсолютной погрешности измерения

Абсолютная погрешность является положительной величиной и может быть выражена в тех же единицах измерения, что и само измеряемое значение. Например, если измеряемая величина выражена в метрах, то и абсолютная погрешность также будет выражена в метрах.

Определить абсолютную погрешность можно при помощи формулы:

Абсолютная погрешность = |Результат измерения - Истинное значение|

Таким образом, зная значение абсолютной погрешности, можно сказать насколько близко полученный результат измерения к истинному значению. Чем меньше абсолютная погрешность, тем более точным считается измерение.

Общая информация об абсолютной погрешности

Абсолютная погрешность обозначается символом Δx и измеряется в тех же единицах, что и сама величина. Она вычисляется путем нахождения разности между измеренным значением и его истинным значением.

Чем меньше абсолютная погрешность, тем более точным считается измерение. Однако, полностью исключить погрешности невозможно, поэтому абсолютную погрешность следует учитывать при интерпретации измерений.

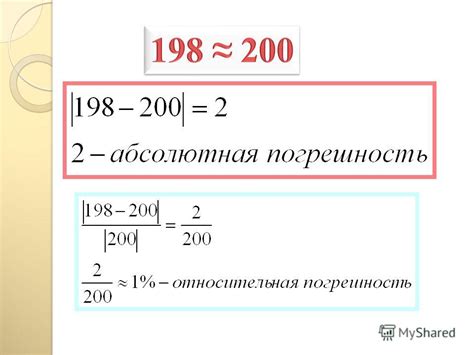

Пример: Если измеренная длина стержня равна 10 см, а его истинная длина - 10,2 см, то абсолютная погрешность составляет 0,2 см.

Абсолютная погрешность также может быть выражена в процентах от измеренного значения. Для этого абсолютную погрешность необходимо разделить на измеренное значение и умножить на 100%.

Пример: Если абсолютная погрешность измерения равна 0,2 см, а измеренное значение составляет 10 см, то абсолютная погрешность в процентах будет равна (0,2 / 10) * 100% = 2%.

Знание абсолютной погрешности позволяет оценить точность измерения и учесть возможное отклонение результатов. Это полезно во многих научных и инженерных областях, где точность измерения имеет большое значение.

Определение относительной погрешности измерения

Относительную погрешность можно рассчитать с помощью следующей формулы:

Относительная погрешность = (Абсолютная погрешность / Измеряемое значение) * 100%

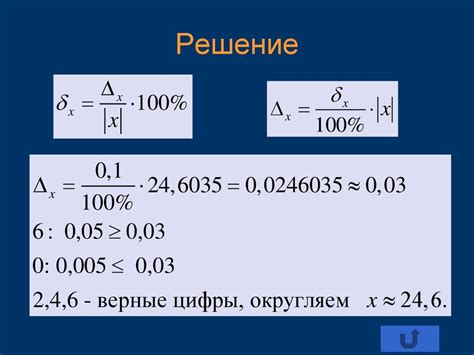

Например, пусть у нас есть измеряемое значение длины равное 10 см, и абсолютная погрешность измерения этой длины составляет 0.5 см. Рассчитаем относительную погрешность:

Относительная погрешность = (0.5 см / 10 см) * 100% = 5%

Таким образом, относительная погрешность измерения равна 5%. Это значит, что измеряемая длина может отличаться от истинного значения на 5%. Чем меньше относительная погрешность, тем точнее измерение.

Относительная погрешность измерения позволяет сравнивать точность различных измерений, проведенных в разных единицах измерения. Например, при измерениях в метрах и дюймах, относительная погрешность позволит сравнить их точность.

Важно учитывать, что относительная погрешность измерения зависит от абсолютной погрешности и измеряемого значения. Поэтому для более точных результатов измерений необходимо минимизировать абсолютную погрешность и проводить измерения с большей точностью.

Понятие относительной погрешности и её использование

Относительная погрешность выражается в процентах или долях и позволяет оценить точность измерений независимо от их абсолютных значений. Она определяется как отношение абсолютной погрешности к значению измеряемой величины и умножается на 100%. Формула для вычисления относительной погрешности выглядит следующим образом:

| Относительная погрешность: | Погрешность / Значение величины * 100% |

Относительная погрешность играет важную роль при сравнении точности различных измерений или при оценке качества экспериментальных данных. Более низкая относительная погрешность указывает на более точное измерение и, следовательно, более надежные результаты. Измерения с высокой относительной погрешностью могут быть менее достоверными и требовать дополнительных проверок или повторных измерений.

Относительная погрешность также используется для установления предельных значений погрешности в различных областях науки и техники. Например, в некоторых спецификациях или стандартах могут быть указаны предельные значения относительной погрешности, которые не должны быть превышены в процессе измерения или производства.

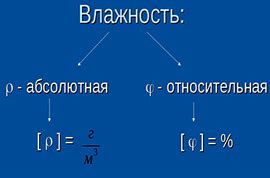

Разница между абсолютной и относительной погрешностями

Абсолютная погрешность представляет собой разность между измеренным значением и его точным значением. Она является количественной характеристикой погрешности и обозначается символом Δ (дельта). Абсолютная погрешность позволяет определить, на сколько измеряемое значение может отличаться от своего истинного значения. Чем меньше абсолютная погрешность, тем более точно проведено измерение.

Относительная погрешность выражает отношение абсолютной погрешности к измеренному значению. Она помогает оценить точность измерения в процентном соотношении. Относительная погрешность часто выражается в процентах и обозначается символом ε (эпсилон). Чем меньше относительная погрешность, тем выше точность измерения.

Абсолютная и относительная погрешности тесно связаны между собой. Зная абсолютную погрешность, можно вычислить относительную погрешность с помощью формулы ε = Δ/х * 100%, где Δ - абсолютная погрешность, х - измеренное значение. Поэтому, для более точного определения точности измерений, необходимо учитывать и абсолютную, и относительную погрешности.

Пример использования абсолютной и относительной погрешностей:

| Измеряемая величина | Измеренное значение (х) | Абсолютная погрешность (Δ) | Относительная погрешность (ε) |

|---|---|---|---|

| Длина (м) | 10.35 | 0.05 | 0.48% |

| Масса (кг) | 2.75 | 0.03 | 1.09% |

| Время (сек) | 15.6 | 0.2 | 1.28% |

В данном примере, абсолютная погрешность показывает, на сколько могут отличаться измеренные значения от их истинных значений. Относительная погрешность же позволяет сравнить точность измерений в процентном соотношении.

Таким образом, абсолютная и относительная погрешности предоставляют информацию о точности измерений и являются важными характеристиками в оценке результатов экспериментов и научных исследований.